Nightshade e Glaze: il veleno che permette di proteggere le opere dai furti dell’Ai

È chiaro a tutti che l’intelligenza artificiale sta rimodellando i contorni della creatività espandendoli, ma anche creando non pochi problemi in termini di uso non autorizzato delle opere d’arte da parte delle Ai provider per addestrare i loro modelli. Proprio su questo fronte si sta combattendo una guerra su più fronti. Quella legislativa, doverosa per intervenire e legiferare sul controverso e complesso tema della tutela dell’opera d’arte; quella giuridica, con aziende come OpenAI, Meta, Google e Stability AI citate in giudizio da artisti che le accusano di usare senza consenso materiale protetto da copyright; e poi, più sottotraccia, la guerra tecnologica dichiarata all’Ai da parte di software e tool che hanno il fine di proteggere le opere d’arte dal processo di scraping, combattendo la tecnologia con la tecnologia.

Il caso di Nightshade e Glaze: i “disturbatori” di algoritmi

Nel panorama della difesa dei diritti intellettuali l’annuncio della nascita del sistema Nightshade ha creato molta aspettativa nei confronti degli artisti, che sempre più spesso si ritrovano a dover competere con copie artificiali dei propri lavori, prive di ogni autorizzazione. Creato dalla mente di Ben Zhao, docente di informatica all’Università di Chicago, Nightshade promette una piccola rivoluzione. Una volta reso disponibile, entro la fine dell’anno, permetterà agli artisti di inserire cambiamenti invisibili nei pixel delle loro opere prima di caricarle online. Queste modifiche, impercettibili all’occhio umano, sarebbero in grado di “ingannare” l’algoritmo causando malfunzionamenti imprevedibili nei modelli di Ai che vengono addestrati con le immagini. In parallelo, la squadra di Zhao ha dato vita a Glaze, un ulteriore strumento di protezione, che consente agli artisti di mascherare il proprio stile per impedire che venga imitato dalle IA generative. Funziona in modo simile a Nightshade, cambiando i pixel delle immagini in modo che gli algoritmi le interpretino come qualcosa di diverso da ciò che effettivamente mostrano.

Come funziona la tecnologia del data poisoning

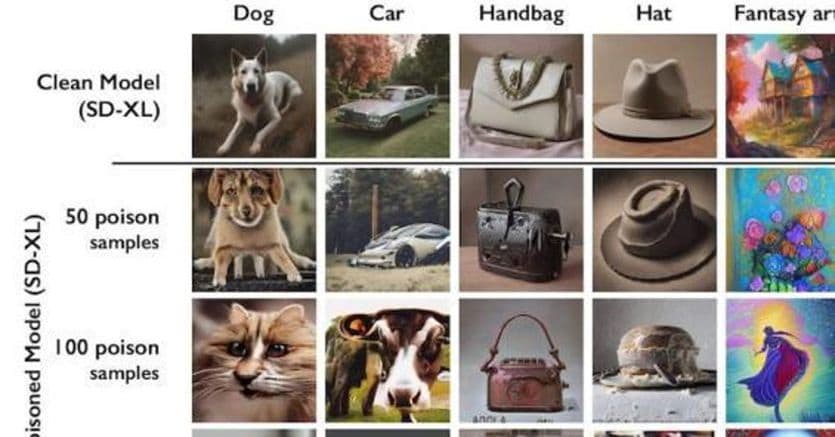

L’obiettivo di questi “tool” è creare confusione nel processo di apprendimento dell’algoritmo al fine di danneggiare le future iterazioni dei modelli generativi di immagini, rendendo alcuni dei loro output caotici e inutilizzabili. Una tecnica meglio conosciuta come “data poisoning“, che aspira a ingannare un modello Ai spingendolo ad interpretare erroneamente la categoria di immagini. Così – come si vede dall’immagine – i cani possono essere scambiati per gatti, automobili per mucche, un cappello per una torta e una borsa per un tostapane. La potenza di Nightshade è stata testata positivamente sui modelli di Stable Diffusion con un insieme di 50 immagini “contaminate”, che date in pasto all’algoritmo hanno iniziato a produrre risultati distorti. Nonostante l’efficacia di Nightshade nell’instillare nei sistemi di addestramento delle Ai una sorta di “veleno digitale”, permangono dubbi sulla possibile manipolazione malevola di tale tecnica. Zhao, però, rassicura: sarebbero necessarie migliaia di immagini alterate per infliggere danni concreti ai modelli Ai di maggior calibro. “Nightshade e Glaze potrebbero anche essere il catalizzatore di una trasformazione più estesa nelle pratiche di rispetto della proprietà intellettuale da parte delle intelligenze artificiali generative”, ha affermato Zao e Junfeng Yang, professore di informatica alla Columbia University, interpellata dal MIT, ha affermato che Nightshade potrebbe indurre le società di intelligenza artificiale a rispettare maggiormente i diritti degli artisti, inducendoli a pagare royalties agli artisti.Le mosse degli Ai providerIn uno scenario segnato da continue battaglie legali e preoccupazioni sempre più incipienti da parte delle istituzioni e di associazioni di categoria, alcuni Ai provider stanno cercando di favorire pratiche concilianti. È il caso di OpenAI, che nella versione aggiornata di DALL-E 3, ha introdotto nuove funzionalità per permettere agli artisti di sottrarre le proprie creazioni dal processo di addestramento e usando dei filtri per evitare la generazione di immagini che emulino lo stile di artisti ancora in vita. Un passo avanti, ma che molti analisti appare solo come una misura “tampone”, dato che non prende in considerazione le opere già pubblicate e assorbite negli archivi digitali della Ai.

Fonte: Il Sole 24 Ore